Premios Nobel de Física y Química para herramientas de Inteligencia Artificial aplicada

4 noviembre, 2024

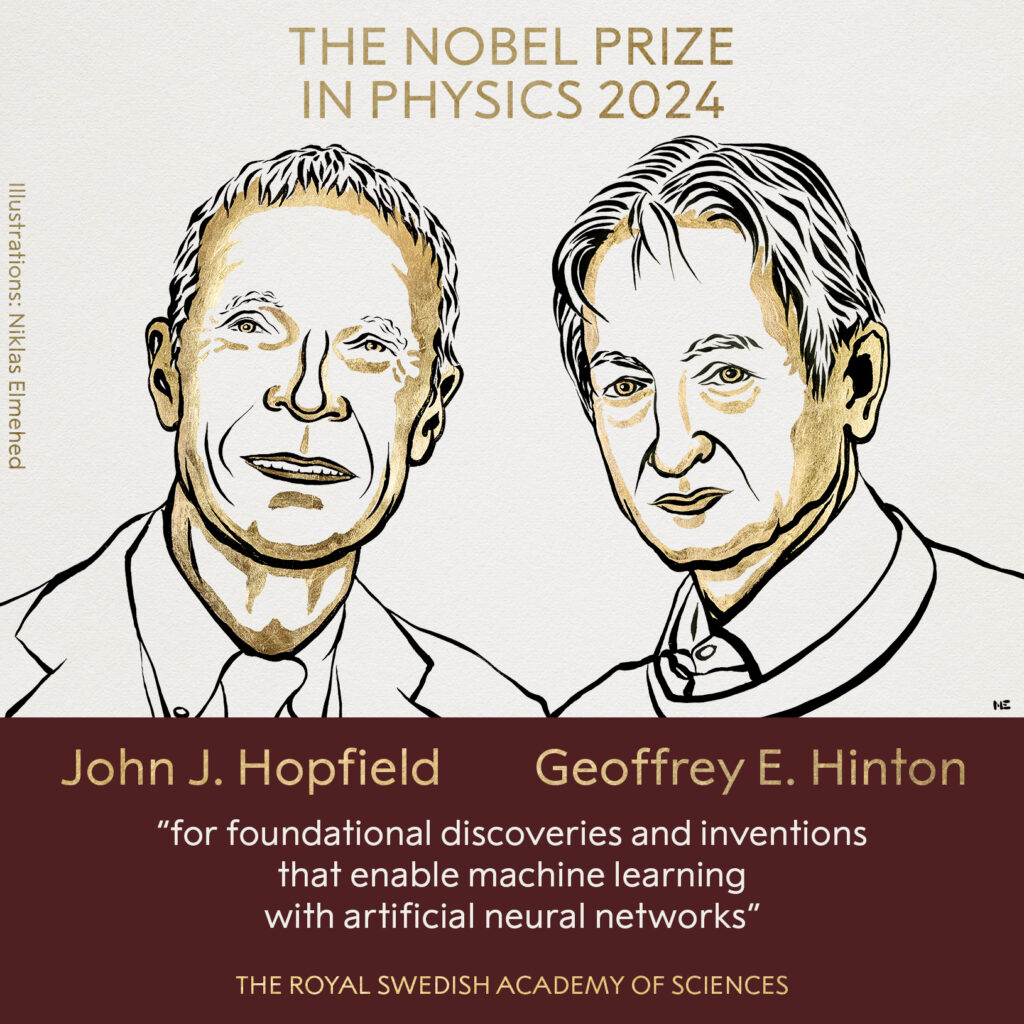

Este año, la Real Academia de las Ciencias de Suecia anunció, por un lado, el Premio Nobel de Física ex aequo para dos investigadores de inteligencia artificial (IA), Jonh Hopfield (Universidad de Princeton) y Geoffrey E. Hinton (Universidad de Toronto) y, por el otro, el Premio Nobel de Química 2024 compartido entre David Baker (Universidad de Washington) por el diseño computacional de proteínas y, de forma conjunta, a Demis Hassabis y John Jumper (Google DeepMind) por la predicción de estructuras de proteínas.

Premio Nobel de Física

En su anuncio la Academia destaca que “Los galardonados de este año utilizaron herramientas de la física para construir métodos que ayudaron a sentar las bases del potente aprendizaje automático actual”. Hopfield creó una estructura que puede almacenar y reconstruir información, las redes de Hopfield en 1982, y Hinton inventó el mecanismo de aprendizaje de sistemas con múltiples capas de neuronas artificiales (backpropagation), un método que permite descubrir propiedades en los datos de forma independiente y que tiene una importancia capital para el aprendizaje de los grandes modelos de redes neuronales artificiales que se utilizan actualmente.

¿Qué significan estos avances y los resultados de estos investigadores en el escenario actual de la inteligencia artificial?

En los años setenta e inicio de los ochenta se estaba viviendo el llamado “invierno de la IA”. Los de entonces no estaban a la altura de las altas expectativas e inversiones. Se había demostrado que lo modelos neuronales de entonces (el perceptrón, con una sola capa de neuronas) no podían resolver problemas complejos. Los modelos simbólicos como los sistemas expertos tenían un alcance práctico muy limitado.

Los resultados de Hopfield y Hinton, plantearon de forma independiente sendos descubrimientos que podemos afirmar que fueron determinantes para un renacer de la IA conexionista, modelos con múltiples capas de neuronas artificiales que ayudan a los ordenadores a aprender más de la forma en que lo hace el cerebro humano, proporcionando las bases para el desarrollo de la IA actual, con el aprendizaje profundo, nombre que reciben los grandes modelos de múltiples capas de neuronas artificiales (deep learning en inglés) como tecnología principal.

El premio reconoce la creciente importancia de la inteligencia artificial en la vida y el trabajo de las personas. Las redes neuronales artificiales, gracias a su capacidad para interpretar grandes cantidades de datos, juegan un papel crucial en la investigación científica, incluyendo la física, donde se utilizan para diseñar nuevos materiales, procesar datos de aceleradores de partículas y estudiar el universo. El sistema de IA de DeepMind, GNoME, por sus siglas en inglés, ya se ha utilizado para predecir las estructuras de 2,2 millones de nuevos materiales. Entre ellos, más de 700 han sido creados en el laboratorio y se están probando en la actualidad.

Premio Nobel de Química

En la nota de prensa enviada por la Academia se explica que este año el premio “versa sobre las proteínas”. Por un lado, se ha premiado a David Baker quien “ha logrado la hazaña casi imposible de construir tipos de proteínas completamente nuevos”. Por el otro, se ha premiado a Demis Hassabis y John Jumper quienes han “desarrollado un modelo de IA para resolver un problema de hace 50 años: predecir las complejas estructuras de las proteínas”.

Estos avances han permitido que, en los últimos años, la labor de los investigadores en el área de la bioquímica, biología y medicina puedan dar pasos agigantados. Para darse una idea de la potencialidad de estos descubrimientos tenemos que recordar que hace poco más de una década eran necesario varios años para obtener la estructura de una proteína utilizando la técnica de cristalografía de rayos X, mientras que en la actualidad gracias al trabajo de estos investigadores se puede predecir la estructura de una proteína utilizando Alphafold en tan solo un par de minutos.

Como nota histórica podemos mencionar que la primera versión de AlphaFold obtuvo el primer lugar en la clasificación general de la 13ª edición (2018) de la competición CASP (Critical Assessment of Techniques for Protein Structure Prediction, Evaluación Crítica de Técnicas para la Predicción de la Estructura de Proteínas). Alphafold consiguió predecir estructuras para las cuales no existían modelos previos, es decir, no contaba con información sobre proteínas similares en las cuales basarse, haciendo este trabajo mucho más difícil y dando por tanto un salto de calidad en la predicción de estructuras de proteínas.

¿Pero en qué consisten estas herramientas tan novedosas que han marcado un antes y un después en la investigación?

Tanto RFdiffusion (creado por el grupo de investigación de David Baker) como Alphafold (creado por Demis Hassabis y John Jumper como parte de Google DeepMind) son herramientas que caen en la categoría de Inteligencia Artificial. Por un lado, RFdiffusion fue creada para el diseño de proteínas de novo, es decir, generar proteínas con propiedades estructurales y/o funcionales específicas. Esto lo consiguen gracias al uso de modelos de difusión, los mismos que usa Stable Diffusion para generar imágenes realistas. Por otro lado, Alphafold está basado en un tipo particular de redes neuronales artificiales, llamadas Transformers. Este tipo particular de redes neuronales artificiales desarrolladas en el 2017 por investigadores de Google han revolucionado el mundo y son parte de la razón por la cual la IA está tan de moda actualmente. Puede que te suenen, dado que otras herramientas más mundanas como ChatGPT también utilizan esta tecnología.

La Inteligencia Artificial como herramienta fundamental en el avance científico

Entre los grandes retos del uso de la IA hemos de mencionar los avances en medicina y medio ambiente y cambio climático. En el primer caso, los avances en medicina incluyen, por ejemplo, la detección temprana de ciertos tipos de cáncer. En cuanto al medio ambiente y el cambio climático, modelos como ClimateGPT y NeuralGCM destacan por sus capacidades para estudiar el cambio climático y realizar predicciones meteorológicas precisas de forma mucho más eficientes que modelos convencionales.

Actualmente, destaca el paradigma de la IA generativa, la creación de imágenes y lenguaje, con los grandes modelos de lenguaje (LLM sus siglas en inglés) como su gran exponente (entre ellos el conocido ChatGPT). Los LLM, entrenados con grandes cantidades de datos textuales, pueden procesar y generar lenguaje natural para tareas como traducción y generación de texto. Estos modelos se basan en la arquitectura de Transformers que ya hemos mencionado, que utiliza mecanismos de atención para manejar dependencias a largo plazo en secuencias de texto, superando las limitaciones de modelos anteriores.

Geoffrey Hinton, tras años trabajando con Google, se ha retirado para centrarse en los aspectos éticos de la IA. En un artículo reciente en Science (mayo 2024) “Gestionar los riesgos extremos de la IA en medio del rápido progreso”, aborda los riesgos del rápido avance de la IA, como el uso malicioso y la potencial pérdida de control humano, proponiendo un plan integral que combina investigación y gobernanza proactiva. El desarrollo de una IA fiable (Trustworthy AI en inglés) y centrada en el ser humano es el gran objetivo de esta década. Las regulaciones y propuestas de gobernanza de la Comisión Europea y Naciones Unidas nos permiten tener confianza en el avance hacia una IA segura, gobernable y confiable.

Los resultados de Hopfield y Hinton impulsaron el auge de la IA, iniciando una “primavera de la IA” que ha llevado a un momento de expectación sin precedentes en los últimos 40 años. Investigadores pioneros avanzaron en redes neuronales, y otros científicos se basaron en estos estudios para desarrollar los actuales modelos de IA. Este reconocimiento pone de relieve la relevancia de la IA en la actualidad gracias a décadas de investigación y al esfuerzo colectivo de la comunidad científica. La IA está transformando diversas áreas de la vida humana, desde la mencionada medicina hasta todos los ámbitos de la tecnología y la ciencia.

Texto original de:

Francisco Herrera – Catedrático de Ciencias de la Computación e Inteligencia artificial, Director del Instituto Interuniversitario de Investigación DaSCI, Universidad de Granada, Académico de número de la Real Academia de Ingeniería.

Rocio Celeste Romero Zaliz – Profesora Titular de Universidad en el Departament de Ciencias de la Computación e Inteligencia Artificial Universidad de Graanda, Subdirectora de Investigación, Transferencia y Docencia del Centro de Investigación Tecnologías de la Información y Comunicaciones.

Algunos artículos relacionados en The Conversation:

- Los Nobel de este año: qué tiene que ver la física con la inteligencia artificial

- Nobel de Física para los pioneros de las redes neuronales que sentaron las bases de la IA

- Cuando la biología salta del laboratorio al ordenador… y al Nobel

- Nobel de Química a la estructura de las proteínas una vez más… ¿la última?